今天,英伟达发布了下一代人工智能超级计算机芯片——h200。

h200 属于上一代 h100 gpu 的继任者,基于新的“hopper”架构,是英伟达首款使用 hbm3e 内存的芯片,具有速度更快,容量更大的特点,更适合大型语言模型使用。

根据官方的说法,h200 相比上一代的 h100 有了显著的飞跃,性能提升可以达到 60% 到 90%。英伟达称:“借助 hbm3e,英伟达 h200 以每秒 4.8 tb 的速度提供 141gb 的内存,与 a100 相比,容量几乎是其两倍,带宽增加了 2.4 倍。”

在人工智能方面,hgx h200 在 llama 2(700 亿参数 llm)上的推理速度比 h100 快了一倍。hgx h200 将以 4 路和 8 路的配置提供,还能与 h100 系统中的软件和硬件兼容。

hgx h200将适用于每一种类型的数据中心,如本地、云、混合云和边缘等,预计2024 年第二季度,微软、谷歌、亚马逊等互联网巨头会部署推出相关产品。这些芯片产品将在深度学习和大型语言模型(llm)方面发挥重要作用,比如 openai 的 gpt-4。

此外,超级ai芯片还将被用于数据中心和超级计算机,可以更好的处理诸如天气和气候预测、药物发现、量子计算等任务。

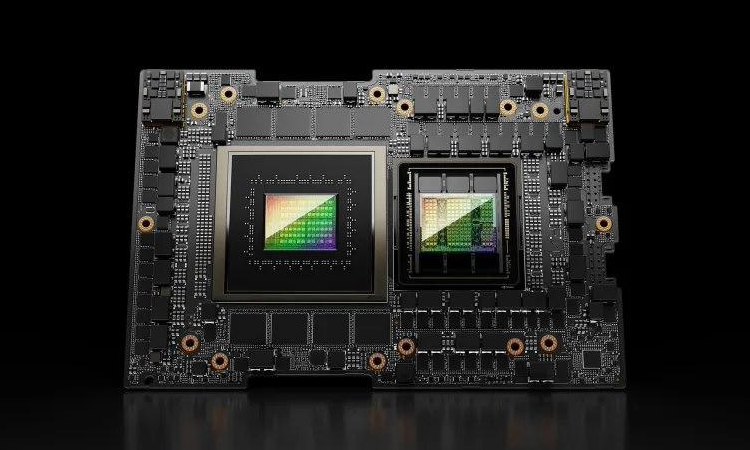

英伟达此次发布的另一个关键产品是 gh200 grace hopper“超级芯片(superchip)”,其将 hgx h200 gpu 和基于 arm 的英伟达 grace cpu 通过该公司的 nvlink-c2c 互连结合起来,官方称其专为超级计算机设计,让“科学家和研究人员能够通过加速运行 tb 级数据的复杂 ai 和 hpc 应用程序,来解决世界上最具挑战性的问题”。

再强也与中国市场无关,特供芯片性能暴降80%

事实上,英伟达发布的ai芯片再强,也与咱们无关。甚至英伟达针对中国推出的特供ai芯片,性能均出现暴降。

美国上月突然宣布,针对英伟达高性能ai芯片管制提前生效,以制约我国ai产业发展。而这也导致英伟达不得不断供一些正在进行的订单,“总处理性能(tpp)”为 4800 或更高的芯片均被要求禁售,a100、a800、h100、h800和l40s等芯片出货均受到影响。

为此,英伟达已确认为中国推出的最新改良版ai芯片,预计会在今年11月至12月送样,而量产时间为今年12月至明年1月。

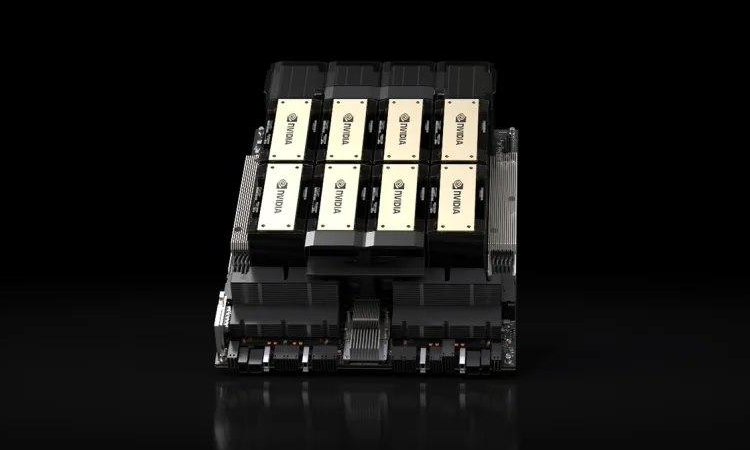

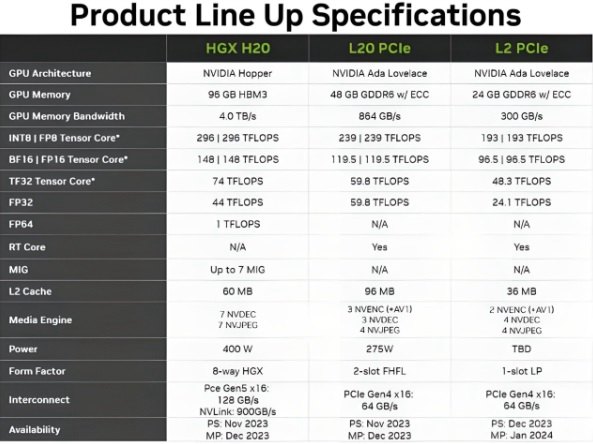

不过,英伟达将推出的三款中国特供ai芯片并非“改良版”,而是“缩水版”,型号分别是hgx h20、l20 pcle和l2 pcle。

用于ai模型训练的hgx h20在带宽、计算速度等方面均有所限制,理论上,整体算力要比英伟达 h100 gpu芯片暴降达80%左右。

尽管相比h100,hgx h20价格会有所下降,但预计该产品价格仍将比国内ai芯片华为的910b高一些。只能说,高性能ai芯片,未来国内的企业或许只能期待华为取得突破了。